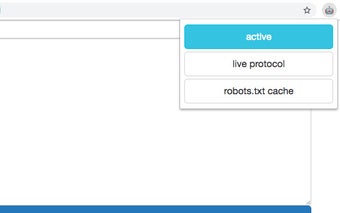

emulator robots.txt: Zablokuj adresy URL na podstawie zasad robots.txt

robots.txt emulator to rozszerzenie Chrome, które umożliwia użytkownikom blokowanie adresów URL na podstawie zasad zdefiniowanych w pliku robots.txt na konkretnych hostach. To rozszerzenie zostało zaprojektowane, aby zapewnić wygodny sposób na sprawdzenie, które adresy URL są blokowane, modyfikowanie pliku robots.txt w czasie rzeczywistym i skorzystanie z jego kompatybilności z Chrome 41.

Za pomocą robots.txt emulator użytkownicy mogą łatwo uniemożliwić dostęp do określonych adresów URL zgodnie z zasadami ustalonymi w pliku robots.txt. Może to być przydatne dla właścicieli stron internetowych, którzy chcą kontrolować dostęp robotów wyszukiwarek do konkretnych stron lub plików. Rozszerzenie zapewnia przyjazny interfejs, który umożliwia przeglądanie i edycję pliku robots.txt na bieżąco, ułatwiając dostosowanie zasad do własnych potrzeb.

Jedną z najważniejszych cech robots.txt emulatora jest jego kompatybilność z Chrome 41. Oznacza to, że użytkownicy korzystający z starszych wersji Chrome nadal mogą skorzystać z funkcjonalności tego rozszerzenia. Bez względu na to, czy jesteś właścicielem strony internetowej, czy programistą, robots.txt emulator oferuje wygodne rozwiązanie do zarządzania dostępem do adresów URL na podstawie zasad z pliku robots.txt.